Was ist ein LLM (Large Language Model)?

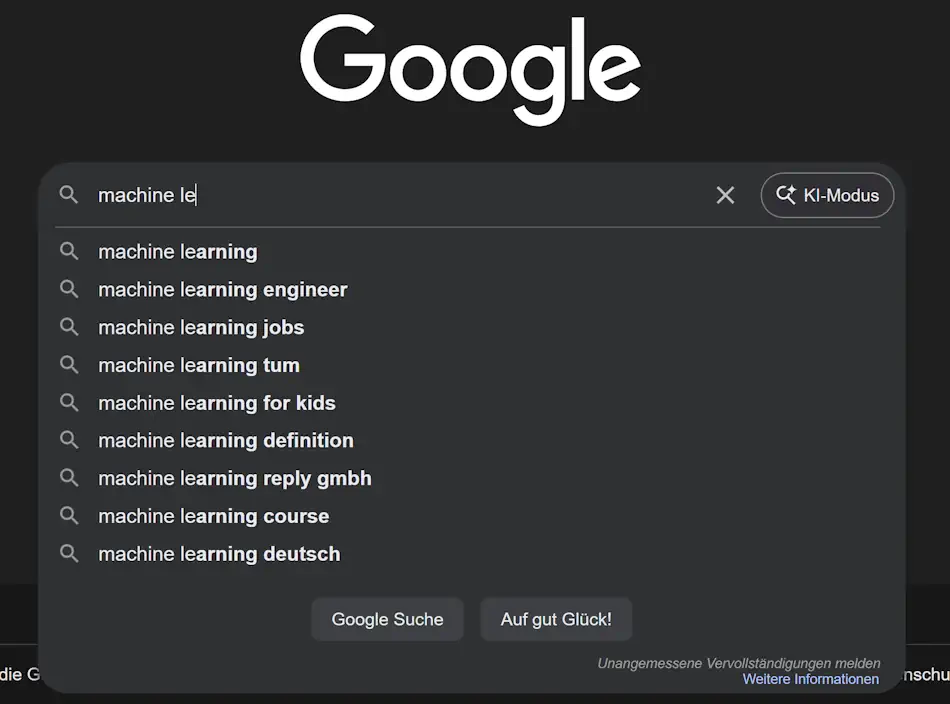

Wenn Ihnen Ihr Smartphone schon einmal das nächste Wort vorgeschlagen hat, das Sie gerade tippen wollten, dann haben Sie bereits den kleinen Vertreter eines Large Language Model (LLM) kennengelernt. Stellen Sie sich nun diese Autovervollständigung in großem Maßstab vor, trainiert mit fast allem, was Menschen online geschrieben haben, und in der Lage, jedes erdenkliche Thema zu diskutieren.

Inhaltsverzeichnis

Wenn Ihnen Ihr Smartphone schon einmal das nächste Wort vorgeschlagen hat, das Sie gerade tippen wollten, dann haben Sie bereits den kleinen Vertreter eines Large Language Model (LLM) kennengelernt. Stellen Sie sich nun diese Autovervollständigung in großem Maßstab vor, trainiert mit fast allem, was Menschen online geschrieben haben, und in der Lage, jedes erdenkliche Thema zu diskutieren.

Das ist es, was ein LLM macht.

Aber hier ist der Unterschied: LLMs denken nicht wirklich, sie sagen voraus.

Die leistungsstarke Autovervollständigung

Wie funktioniert LLM

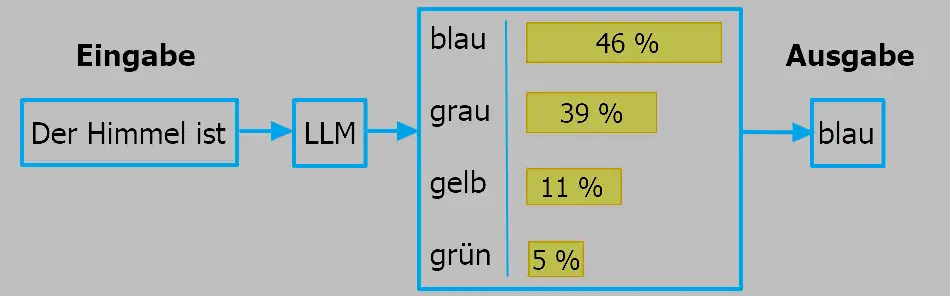

Am einfachsten kann man sich ein LLM als ein sehr fortschrittliches Autovervollständigungssystem vorstellen. Es schaut sich die Wörter an, die Sie geschrieben haben, errät, was wahrscheinlich als Nächstes kommt, und macht so weiter, Wort für Wort, bis es fertig ist.

Im Gegensatz zur Tastatur Ihres Smartphones hat es jedoch Milliarden von Dokumenten gelesen und gespeichert. Es hat gelernt, wie Menschen normalerweise Sätze fortsetzen, wie Ideen einfließen und wie Fragen und Antworten zusammenpassen. Das ist alles!

Das ist im Grunde die einzige Funktion, die wir von einem LLM benötigen, um fortschrittliche Chatbots wie ChatGPT zu entwickeln.

Es "versteht" nicht so wie wir. Es sagt voraus, was richtig klingt, basierend auf den Mustern, die es aus seinem Trainingsprozess gelernt hat.

Deshalb können sie zwar ein Gedicht über Antike Physik schreiben, aber dennoch einfache Rechenaufgaben vermasseln oder an einfachen Rätseln scheitern.

Hinweis: LLMs sind nicht genau dasselbe, womit Sie täglich auf Plattformen wie ChatGPT, Gemini oder Grok interagieren. Dabei handelt es sich um leistungsstarke Versionen von LLMs, die als Agenten bezeichnet werden und über zusätzliche Funktionen wie die Websuche verfügen.

Was LLM eigentlich bedeutet

Lassen Sie uns das Akronym entschlüsseln:

Large (groß): Es ist mit Milliarden von Wörtern trainiert und verfügt über Milliarden von internen Einstellungen, die als Parameter bezeichnet werden. Diese Parameter sind wie einstellbare Regler, mit denen die Textvorhersage fein abgestimmt wird.

Language: Es arbeitet mit menschenähnlichen Texten: Wörtern, Sätzen, Absätzen. Allerdings verwenden sie diese Zerlegung nicht wirklich so wie wir, aber das ist ein Thema für einen anderen Tag. Einige neuere Modelle erweitern dies auch auf Bilder oder Töne, aber Text ist ihr Kerngebiet.

Modell: Es handelt sich um ein mathematisch-statistisches System, das Muster aus Daten lernt. Es ist keine Datenbank mit gespeicherten Fakten. Stattdessen codiert es Wahrscheinlichkeiten: welches Wort folgt am ehesten auf welchen Kontext.

Ein LLM merkt sich also nicht, wo es etwas gesehen hat, sondern generiert tatsächlich das, was passt.

Sobald man aufhört, von einem LLM zu erwarten, dass es etwas weiß, und es stattdessen als etwas betrachtet, das Vorhersagen trifft, macht sein Verhalten viel mehr Sinn.

Der Anfang

Wie jede andere technologische Entwicklung sind auch LLMs keine Ausnahme, sie sind nicht über Nacht entstanden. Sie sind das neueste Kapitel in einer langen Entwicklung, in der Maschinen "gelernt" haben, mit Sprache umzugehen.

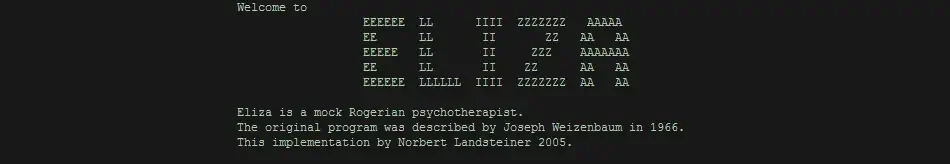

1950er–1980er Jahre

Frühe "KI"-Chatbots basierten auf "handgeschriebenen" Regeln (z. B. "Wenn der Benutzer 'Hallo' sagt, antworte mit 'Hi'"). Jede Antwort musste fest programmiert werden, was die Systeme starr und anfällig machte. Sie wirkten mechanisch, konnten mit unerwarteten Eingaben nicht umgehen und versagten, sobald ein Benutzer etwas anders formulierte.

1990er–2010er Jahre

Der Aufstieg der traditionellen natürlichen Sprachverarbeitung (NLP): Zählen von Wörtern und Ko-Äquivalenten. In dieser Ära vor dem Deep Learning "verstanden" Computer Sprache, indem sie zählten, wie oft Wörter in großen Textmengen zusammen vorkamen. Techniken wie N-Gramme oder TF-IDF konnten das nächste Wort auf der Grundlage früherer Sequenzen vorhersagen oder wichtige Begriffe in einem Dokument identifizieren.

Modelle dieser Ära hatten kein wirkliches Verständnis für Bedeutung, Grammatik oder Kontext. Es war, als würde man eine Sprache lernen, indem man Phrasen aus einem Sprachführer auswendig lernt: nützlich in begrenzten Situationen, aber unsicher und oberflächlich.

2010er Jahre

Mit neuronalen Netzen begannen Modelle, aus Beispielen statt aus Regeln zu lernen. Der Bereich NLP verlagerte sich von handgefertigten Regeln zu Modellen, die Muster direkt aus Daten lernten. Wort-Embedding-Techniken gaben Wörtern numerische "Koordinaten" in einem semantischen Raum, sodass Modelle Regeln wie "Lehrer – Mann + Frau ≈ Lehrerin" entdecken konnten.

Neuere Modelle für NLP wie Recurrent Neural Networks (RNNs) und später LSTMs begannen, Sequenzen effektiver zu verarbeiten und längerfristige Abhängigkeiten zu erfassen. Zum ersten Mal begannen Modelle zu generalisieren: Sie konnten Sätze verarbeiten, die sie noch nie gesehen hatten, und nicht nur auswendig gelernte Muster wiederholen.

2017

Die Ära der Transformer begann mit dem Artikel "Attention Is All You Need". Die Transformer-Architektur ersetzte die sequenzielle Verarbeitung durch einen Mechanismus namens "Self-Attention", der es Modellen ermöglicht, bei der Interpretation eines einzelnen Wortes die Bedeutung aller Wörter in einem Satz zu gewichten. Plötzlich konnte "Schloss" in "Märchenschloss" gegenüber "Fahrradschloss" anhand des gesamten Kontextes unterschieden werden – nicht nur anhand der unmittelbaren Nachbarwörter. Transformer waren schneller zu trainieren, ließen sich nahtlos skalieren und wurden zur Grundlage für alle nachfolgenden großen LLMs.

2022–2025

Mit der Veröffentlichung von ChatGPT Ende 2022 waren LLMs nicht mehr nur Chatbots, sondern wurden zu Agenten: Systeme, die denken, planen und Werkzeuge einsetzen können. Leistungsstarke Modelle wie GPT-4, Claude, Gemini und Open-Weight-Alternativen wie Llama waren nicht mehr auf Forschungslabore beschränkt, sondern wurden über APIs, lokale Laufzeitumgebungen (Ollama, llama.cpp) und Cloud-Plattformen allgemein verfügbar. Nun konnte jeder wirklich nützliche KI-Produkte entwickeln.

Was LLMs tatsächlich leisten können

Durch Mustererkennung und Vorhersage des nächsten Wortes können LLMs lernen, zahlreiche Aufgaben mit hoher Genauigkeit auszuführen. Hier sind einige Beispiele dafür, was sie wirklich gut können:

Sie können schreiben: Von professionellen E-Mails bis hin zu Science-Fiction-Geschichten.

Sie können erklären: Sie können Quantencomputing in einfache Sprache übersetzen.

Sie können übersetzen: Von Englisch ins Arabische oder von Code zu Code.

Sie können zusammenfassen: Sie können umfangreiche Forschungsergebnisse zu den wichtigsten Punkten zusammenfassen.

Sie können Rollenspiele spielen: Als Tutoren, Interviewer oder sogar als Dungeon Master auftreten.

Wenn sie gut angeleitet werden, sind LLMs erstaunlich leistungsfähig. Aber wenn sie unkontrolliert bleiben, liegen sie mit Sicherheit falsch. Deshalb müssen wir verstehen, wie sie funktionieren, um zu verstehen, was wir von ihnen erwarten können und vor allem, wo ihre Grenzen liegen.

Was LLMs nicht können

Lassen Sie uns zunächst ihre Grenzen erkennen.

- LLMs verstehen Bedeutung nicht, sie simulieren sie.

- LLMs verfügen über kein Echtzeitwissen, es sei denn, sie sind mit Live-Daten verbunden.

- LLMs haben Schwierigkeiten mit tiefgreifenden Schlussfolgerungen oder Ursache-Wirkungs-Logik.

- LLMs speichern von Natur aus keine Gesprächshistorie.

- LLMs können halluzinieren und sich Dinge mit voller Überzeugung ausdenken.

imgDeshalb sollte selbst die ausgefeilteste Antwort noch hinterfragt werden.

Sprachgewandtheit ist nicht gleichbedeutend mit Wahrheit.

Die größten Mythen entlarven

Lassen Sie uns einige verbreitete Missverständnisse aufgreifen.

LLMs wissen alles

Sie wissen nur das, worauf sie trainiert wurden, und erfinden den Rest gerne.

Sie sind intelligent oder bewusst

Sie sind hochentwickelte Musterwiederholer ohne jegliches Bewusstsein.

Wenn es richtig klingt, muss es auch richtig sein

Sprachgewandtheit verbirgt oft sachliche Fehler. Überprüfen Sie daher immer, was LLMs generieren.

Warum dies wichtig ist

Nachdem wir nun die Intuition hinter LLMs und ihre tatsächliche Funktionsweise entwickelt haben, sind Sie in einer viel besseren Position, um sie sinnvoll einzusetzen.

Das heißt:

- Beginnen Sie, ihre Schwachpunkte zu erkennen und ihre Schwächen zu identifizieren.

- Vermeiden Sie es, sich von selbstbewusstem Unsinn irreführen zu lassen.

- Erkennen, wo Automatisierung Ihre eigene Arbeit ergänzen kann, anstatt sie zu ersetzen.

Wenn Sie das nächste Mal mit einem KI-Assistenten sprechen, halten Sie einen Moment inne.

Beachten Sie, dass er nicht aus dem Gedächtnis antwortet, sondern nur das nächstbeste Wort vorhersagt, und das milliardenfach pro Sekunde.

Diese veränderte Perspektive ist Ihr erster Schritt zur Kompetenz.